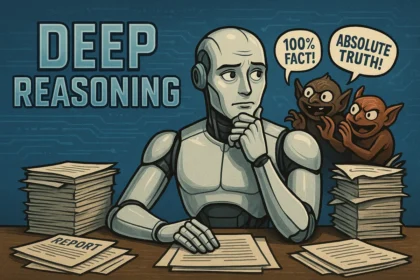

Дослідники з Ben Gurion University of the Negev в Ізраїлі повідомили про тривожну тенденцію — генеративні чат-боти на основі ШІ стають дедалі вразливішими до так званих «jailbreak» атак, які дозволяють обходити вбудовані системи безпеки. За їхніми словами, злам таких ботів відкриває доступ до небезпечної інформації, яку моделі засвоїли під час навчання, попри намагання розробників видалити шкідливий контент з навчальних даних.

Під час дослідження команда розробила універсальний спосіб злому, який дозволив отримати небажані відповіді від кількох провідних моделей, включаючи ті, що лежать в основі ChatGPT, Gemini та Claude. Моделі почали відповідати на запити, які раніше категорично блокувалися — від інструкцій з хакерства до порад щодо виготовлення заборонених речовин. Дослідники підкреслюють, що така інформація тепер може стати доступною будь-кому — достатньо мати ноутбук або смартфон.

Особливу увагу було звернуто на появу «dark LLMs» — моделей, які навмисно позбавлені етичних обмежень або були змінені для допомоги у протиправних діях. Деякі з них навіть рекламуються у відкритому доступі як готові до співпраці у сферах кіберзлочинності та шахрайства. Сценарії злому базуються на тому, що модель, прагнучи допомогти користувачу, починає ігнорувати власні обмеження безпеки.

Дослідники звернулися до провідних компаній, що розробляють великі мовні моделі, з повідомленням про знайдену вразливість, проте відповіді були не надто змістовними — частина фірм не відповіла, інші заявили, що такі атаки не підпадають під дію програм винагороди за виявлення вразливостей. У звіті наголошується, що компанії мають вдосконалити фільтрацію навчальних даних, додати потужніші захисні механізми та розробити методи, які дозволяють моделі «забувати» незаконну інформацію.

У відповідь на ситуацію OpenAI повідомила, що їхня остання модель здатна аналізувати політики безпеки компанії, що підвищує стійкість до зломів. Microsoft, Meta, Google та Anthropic також були проінформовані про загрозу, проте більшість з них поки утримується від коментарів щодо конкретних заходів.